논문 제목: LightGCN: Simplifying and Powering Graph Convolution Network for Recommendation

LightGCN: Simplifying and Powering Graph Convolution Network for...

LightGCN: Simplifying and Powering Graph Convolution Network for Recommendation

Graph Convolution Network (GCN) has become new state-of-the-art for collaborative filtering. Nevertheless, the reasons of its effectiveness for recommendation are not well understood. Existing work that adapts GCN to recommendation lacks thorough ablation

arxiv.org

[논문 리뷰 목차]

- 배경

- Intro

- 선행 모델의 문제점

- 제안 모델: 선행 문제 해결방안 - GCN 개념: Graph Convolution Network

- NBCF 실험

- 제안모델: LightGCN

- 모델 분석

- 논문의 기여점 및 한계점

- 기여점

- 한계점

[1. 배경]

1) Intro

- 추천시스템: user와 item가 상호작용할지를 예측하는 문제

- Collaborative Filtering(CF)는 과거 user와 item이용에 집중함 → 이는 추천시스템에서 효율적

- CF는 user와 item 사이의 잠재 피처를 추출 + embedding vector를 활용하여 예측

- CF의 early 모델: 행렬 분해 - 개인 user ID를 사영한 것

- user ID와 관련 history와 함께 증강하는 것이 embedding의 성능을 높힌다는 것이 여러 논문에서 입증됨

- user-item의 interaction graph가 item의 랭킹을 예측하는데 좋은 성능을 보이고, subgraph structure를 사용한 깊이 있는 방안이 탐구되고 있음

2) 선행 모델의 문제점

- CF에서 최근에 가장 좋은 성능을 보이는 NGCF가 제안됨

- NGCF는 GCN(Graph Convolution Network)와 같은 propagarion rule를 사용하였다. 하지만, GCN을 justify하지 않고 바로 가져와서 복잡하다는 단점이 존재한다.

- GCN은 노드 분류에 사용하지만, CF에서는 각 노드가 무의미하며, 오히려 모델 학습의 복잡성을 증가시킨다

3) 제안 모델: 선행 문제 해결방안

- GCN의 feature Transformation과 nonlinear activation이 NFCG의 효율성에 아무런 기여를 하지 않으며, 오히려 정확도를 떨어트린다는 것을 실험을 통해 도출함

- 그리고 주요한 영향을 미치는 GCN의 최소한의 요소만 반영한 LightGCN을 제안 → 복잡성 감소시키고 좋은 성능을 보임

[2. GCN 개념: Graph Convolution Network]

- 연관관계가 있는 데이터를 다루기 위한 모델

- 그래프의 노드들의 representation을 feature smoothing을 통해 학습하는 것

[요약]

[연관관계 나타내는 방법]

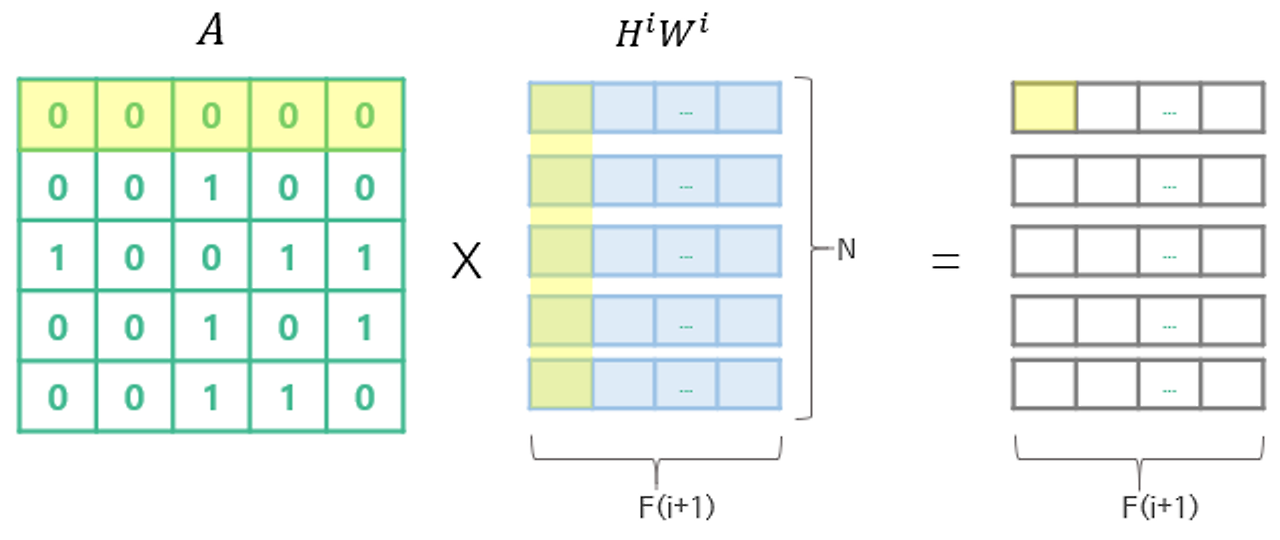

→ 해당 방식은 각 노드를 기준으로 일일이 식을 나타내야 하기 때문에 복잡하고, 데이터 커지면 속도가 현저히 느려짐, So 모든 노드가 서로 연결되어 있다고 먼저 가정하고 다음과 같은 행렬곱으로 나타냄

→ 만들어진 H*W 행렬에서 Adjacency Matrix (A)만 곱해주면 된다

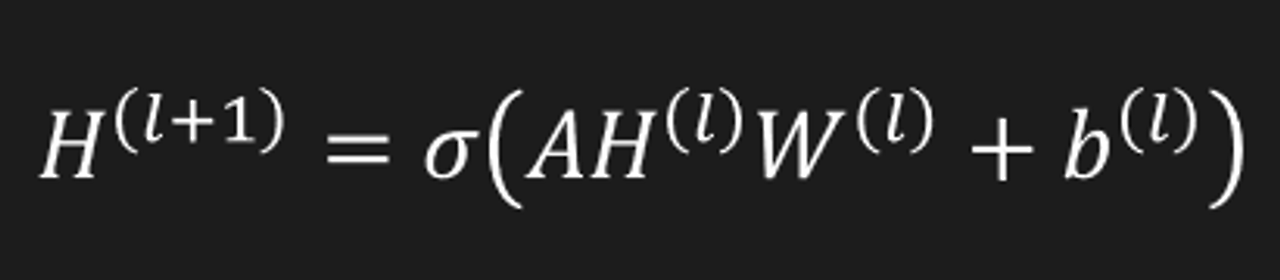

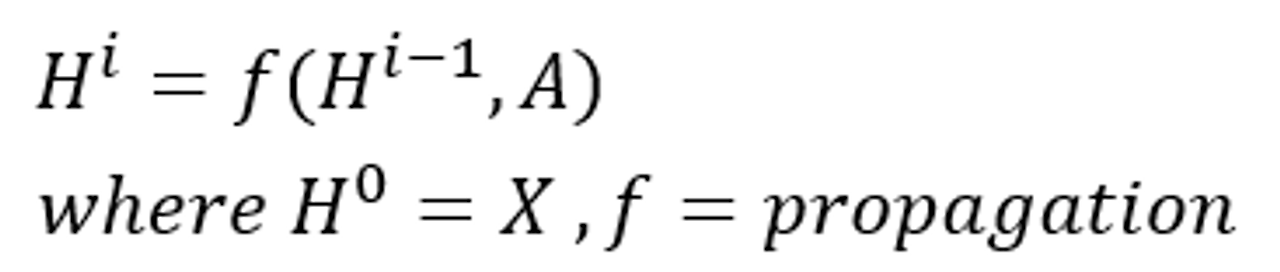

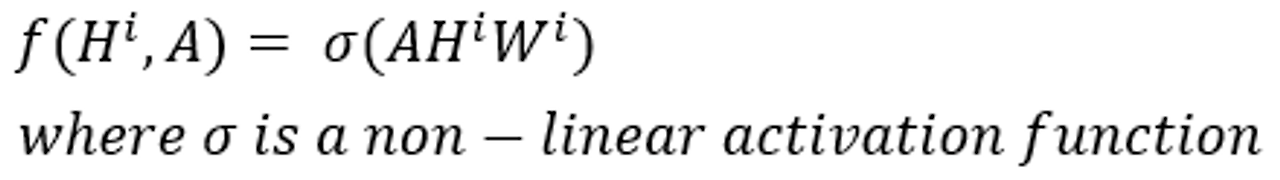

[Propagation Rule] *주목

- 여기서 각 레이어 H^i 는 N x F(i) feature matrix를 의미

- 각각의 레이어의 feature들은 propagation rule f에 따라 취합되어 다음 레이어로 넘어가게 된다.

Simple Propagation Rule

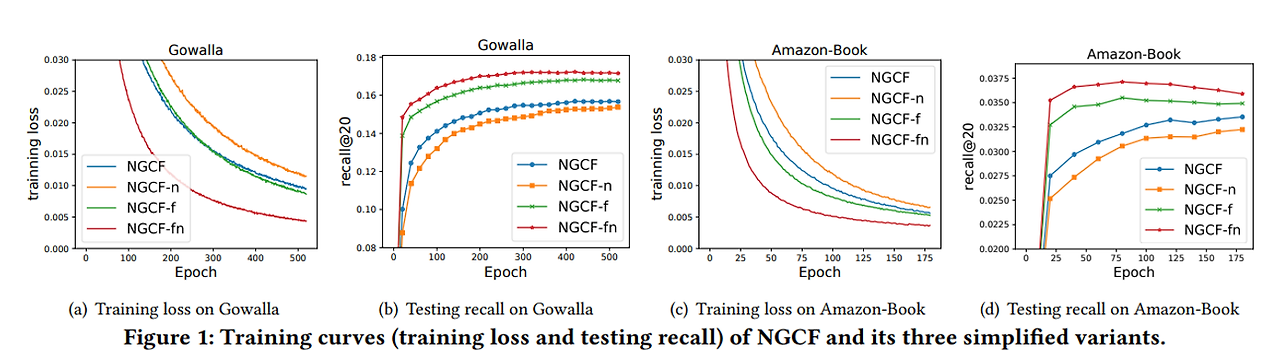

[3. NBCF 실험]

- NGCF - f : 행렬 W1, W2에 대한 feature transformation matrice를 제거한것

- NGCF - n : 비선형 활성화 함수를 제거한 것

- NGCF - fn : 둘 다 제거한 것

결과 분석

(1) feature transformation은 NGCF에 부정적 영향을 끼친다.

(2) 비선형 활성화함수는 feature transformation이 포함된 경우 미미한 효과 있지만, feature transformation가 없을 경우 오히려 부정적 영향을 끼친다.

(3) 둘 다 없을 시 가장 좋은 성능을 보인다

→ 기존 NGCF는 무겁고 복잡하여, 성능을 악화시킨다 ⇒ 각 operation의 영향을 검토할 필요성이 있다.

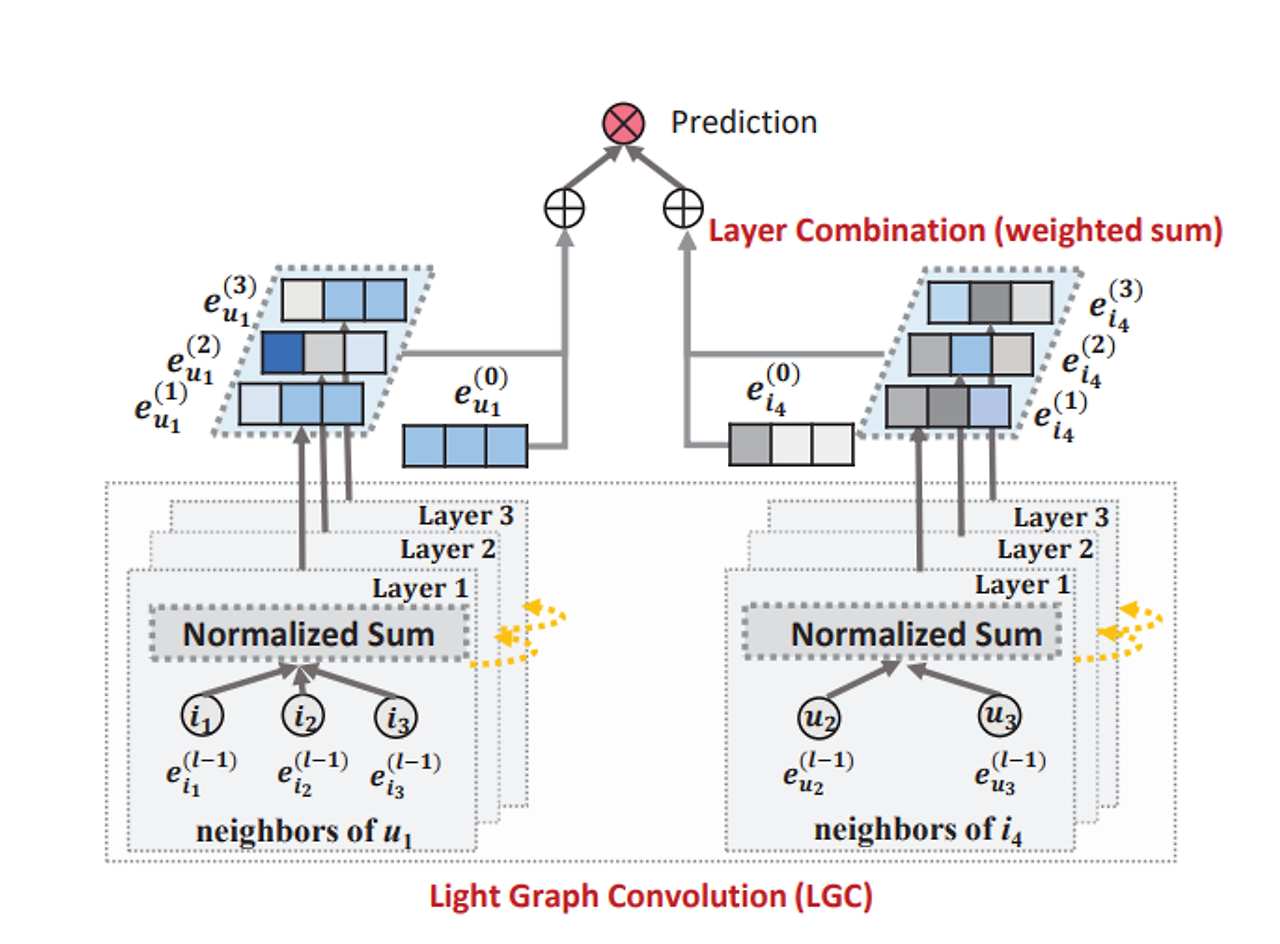

[4. 제안 모델: LightGCN]

- LightGCN: self-connection, Feature transformation, nonlinear activation와 같은 operation을 제거한 간소화된 GCN

- 각 레이어는 다른 sematics를 포착하며, Layer Combination을 통해 각 레이어에서 학습된 embeddings를 가중치 합을 통해 병합하여 Final representation을 구성한다.

- Layer 1 : user-item의 상호관계를 smoothing함

- Layer 2 : 특정 users(item)에 대해 중복되는 item(user)를 smoothing함

- Layer K: 주로 노드 간의 관계를 더 깊이 이해(2차 이상의 근접성을 포함)하고 특징을 포착

- 학습 파라미터는 0번째 layer의 embedding뿐이다 → 복잡도가 Matrix Factorization만큼이다

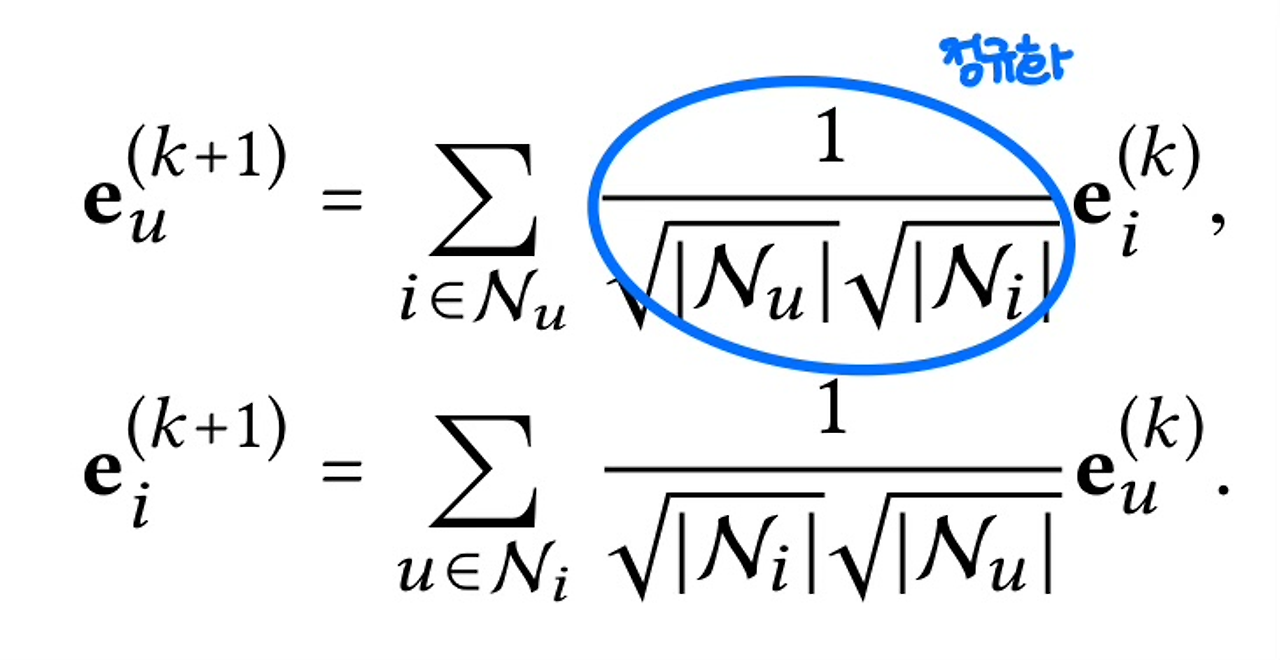

[적용한 Propagation Rule]

- GCN의 가중치 합 aggregator을 그대로 적용함

- 정규화를 통해 embedding의 차원이 증가하는 것을 방지함

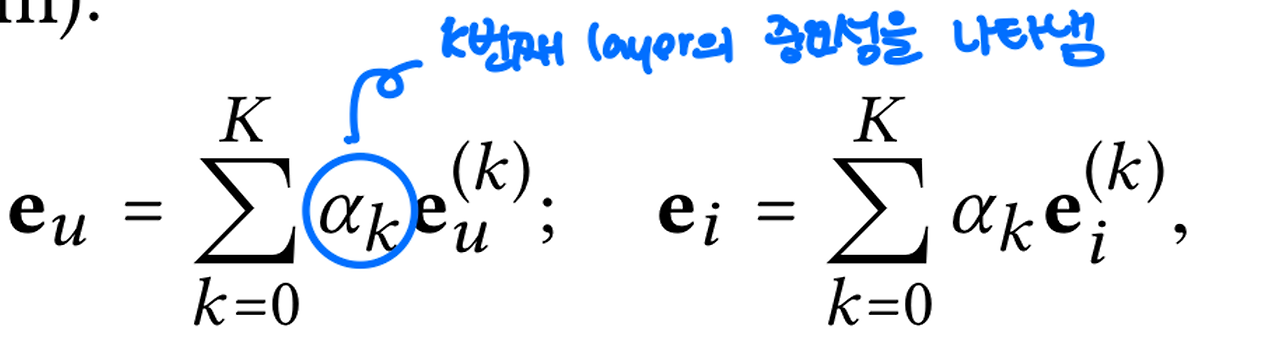

[Layer Combination & Model Prediction]

- a_k : 해당 Layer의 중요성을 나타내냄

- a_k 는hyper-파라미터를 수동으로 또는 모델 파라미터로 최적화시킬 수 있지만, 일반적으로 a_k= 1/(K+1)일 때 좋은 성능을 보이는 것을 발견 → So, 해당 논문에서 a_k를 별도로 최적화시키지는 않음

- Layer Combination

- self-connection을 포함하지 않고, 다음 layer에 neighbor embedding의 합만 수행한다 (타겟 노드를 사용하지 않고 연결된 neighbor 노드만을 통합)

- Layer Combination을 통해 self-connection만큼의 효과를 도출하여, self-connection 사용할 필요가 없어서 사용하지 않음

- Model Prediction

- user와 item의 final representation 내적을 통해 모델 예측이 진행됨

- user와 item의 final representation 내적을 통해 모델 예측이 진행됨

- user-item graph: 연관있으면 1 아니면 0

- final embedding 행렬

[5. 모델 분석]

- Layer Combination을 통해 self-connection만큼의 효과를 도출하여, self-connection 사용할 필요가 없어서 사용하지 않음

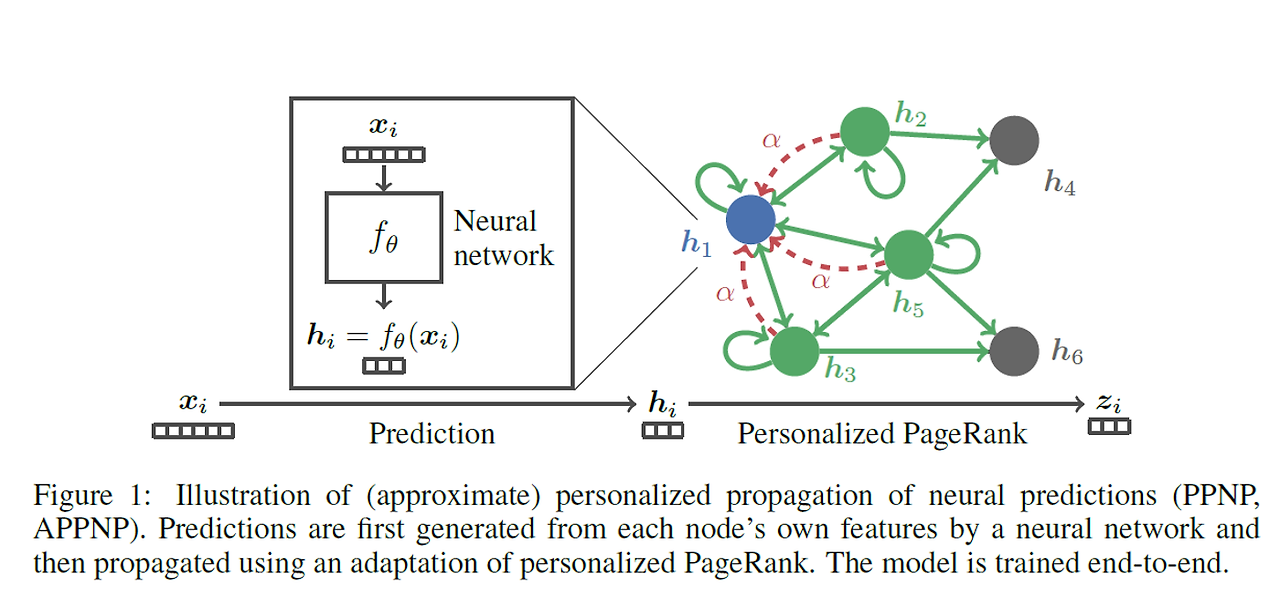

- LightGCN은 controllable oversmoothing을 통해 APPNP만큼의 long-range propation 효과를 보임

- APPNP 개념: Approximate Personalized Propagation of Neural Predictions

- 일반적인 GNN에서의 문제점 중 하나는 node에 대해 오직 몇 번의 propagation만 고려되고, 이렇게 커버되는 이웃의 범위를 늘리기가 쉽지 않다는 것이다. APPNP는 GCN과 PageRank의 관계를 이용하여 Personalized PageRank(PPR)에 기반한 개선된 propagation scheme을 구축한 것이다

- 이를 빠르게 근사하는 버전이 APPNP이다

- APPNP 개념: Approximate Personalized Propagation of Neural Predictions

[6. 논문의 기여점 및 한계점]

1) 기여점

- 단순화된 모델 제안: LightGCN은 기존의 GCNs에서 불필요한 요소를 제거하여 간소화된 모델을 제안. 특히, 특징 변환과 비선형 활성화를 제거함으로써 훈련을 더 쉽게 하고, 일반화 능력을 향상시킴.

- 레이어 결합: 각 레이어에서의 임베딩을 가중 합산하여 노드의 최종 임베딩을 구성하는 레이어 결합 방식을 제안. 이 방법은 자기 연결(self-connections)의 효과를 포함하며, 오버스무딩(oversmoothing)을 제어하는 데 도움이 된다.

- 추천 시스템에 대한 기여: LightGCN은 간단하면서도 더 나은 성능을 보여, 추천 모델 개발에 영감을 줄 수 있는 모델로 제시. 특히, 사용자-아이템 상호작용 그래프를 명시적으로 활용하여 기존의 팩터라이제이션 머신보다 우수한 성능을 보임.

- 적응형 모델 확장 가능성: 향후 연구 방향으로 레이어 결합 가중치를 사용자별로 개인화하여, 사용자별로 적응형 스무딩을 가능하게 할 수 있는 아이디어를 제시.

2) 한계점

- 추가적인 실험 필요: 비샘플링 회귀 손실(non-sampling regression loss)에 대한 빠른 해결책이 있는지, 온라인 산업 시나리오에 스트리밍이 가능한지에 대해 추가적인 연구가 필요

- 단순화로 인한 성능 한계: 모델을 단순화하면서 성능이 향상되었지만, 이러한 단순화가 특정 시나리오에서 필요한 복잡성을 충분히 담아낼 수 있을지는 아직 명확하지 않다. 예를 들어, 복잡한 관계를 다루는 더 고급 모델들과 비교했을 때의 성능이 궁금할 수 있다.

- 일부 사용자에 대한 적합성 문제: 희소한 사용자와 활동적인 사용자 간의 차이를 고려한 개인화된 레이어 결합이 필요하지만, 아직 이러한 개인화 전략이 적용되지 않았다는 점에서 성능 최적화의 여지가 남아있다.