Radford, Alec, et al. "Learning transferable visual models from natural language supervision." International conference on machine learning. PMLR, 2021.

Learning Transferable Visual Models From Natural Language Supervision (mlr.press)

Learning Transferable Visual Models From Natural Language Supervision

State-of-the-art computer vision systems are trained to predict a fixed set of predetermined object categories. This restricted form of supervision limits their generality and usability since addit...

proceedings.mlr.press

Abstract

본 페이지에서는 해당 연구를 이해의 편의를 위해서 배경 및 제안모델 요약, 제안모델 설명, 평가 결과 분석, 논문의 한계 및 기여점 순으로 정리합니다. 개인적인 분석이므로, 해당 논문에 대한 평가가 아닌 '해당 논문이 어떠한 내용이다'를 정리한 논문 리뷰로서 참고하고 봐주시면 감사하겠습니다. 더욱 자세한 내용을 위해서는 첨부된 논문을 읽어주세요:)

또한, 해당 모델의 해당 모델의 코드와 사전 훈련된 모델 가중치가 https://github.com/OpenAI/CLIP 에 공개되어 있습니다. 확인하시고 싶으신 분들을 Github 링크 들어가서 확인해주시면 될 것 같습니다.

*선행연구의 논문이 보고 싶다면, 본 논문의 references에서 확인 부탁드립니다:)

언제든 피드백은 환영입니다:)

배경 및 제안 모델 요약

[최근 연구 방향]

- 지난 몇 년 동안 원시 텍스트로부터 직접 학습하는 사전 훈련 방법은 NLP를 혁신을 불러옴

- 제로샷 전이가 가능해지면서, GPT-3와 같은 주요 시스템은 이제 맞춤형 모델과 경쟁력을 가지며 거의 데이터셋 특정 훈련 데이터가 필요하지 않다

"그러나"

- 컴퓨터 비전과 같은 다른 분야에서는 아직도 ImageNet과 같은 크라우드 라벨링된 데이터셋에서 모델을 사전 훈련시키는 것이 표준 방법이다 (Deng et al., 2009)

"웹 텍스트에서 직접 학습하는 확장 가능한 사전 훈련 방법이 컴퓨터 비전 분야에서도 유사한 발전을 가져올 수 있을까?

YES"

- Joulin et al. (2016)은 이미지 캡션에서 단어를 예측하도록 훈련된 CNN이 ImageNet 훈련과 경쟁력 있는 표현을 학습할 수 있음을 입증함

- Li et al. (2017)은 이 접근 방식을 단어뿐만 아니라 구문 n-그램을 예측하는 것으로 확장했으며, 시스템이 다른 이미지 분류 데이터셋으로의 제로 샷 전이 능력을 입증함

- VirTex (Desai & Johnson, 2020), ICMLM (Bulent Sariyildiz et al., 2020) 및 ConVIRT (Zhang et al., 2020)는 트랜스포머 기반 언어 모델링, 마스킹 언어 모델링 및 대조적 목적을 사용하여 텍스트에서 이미지 표현을 학습하는 잠재력을 입증

=> 하지만, 여전히 상기 모델들은 여전히 현재 SOTA 컴퓨터 비전 모델인 Big Transfer (Kolesnikov et al., 2019) 및 약간 감독된 ResNeXt (Mahajan et al., 2018)보다 성능이 낮다.

- Mahajan et al. (2018) 및 Kolesnikov et al. (2019)은 수백만에서 수십억 개의 이미지에 대해 가속기 년 동안 훈련을 받았으나, VirTex, ICMLM 및 ConVIRT는 가속기 하루 동안 1에서 20만 개의 이미지에 대해 훈련을 받음

=> 데이터셋 규모가 여전히 작음

[제안 모델 요약]

요약:

- 데이터 규모 격차를 메우고, 대규모로 자연어 감독에서 훈련된 이미지 모델의 행동을 연구

- ConVIRT의 간소화된 버전인 CLIP(대조적 언어-이미지 사전 훈련)라고 부르는 scratch에서 훈련된 효율적이고 확장 가능한 자연어 감독 학습 방법

- CLIP은 사전 훈련 중에 OCR, 지리 위치 결정, 액션 인식 등의 다양한 작업을 수행하는 것을 배움

결과:

- 최고의 공개 ImageNet 모델보다 더 계산적으로 효율적인 동시에 이 작업을 뛰어넘는 성능을 발휘

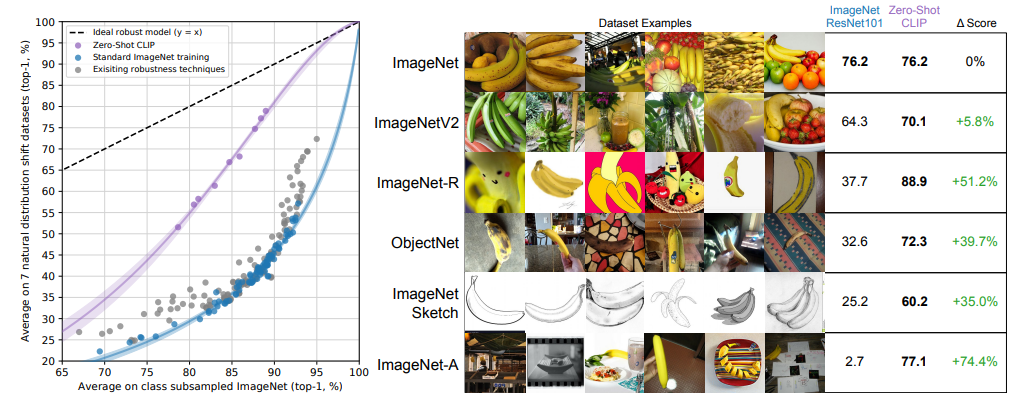

- 제로 샷 CLIP 모델이 동등한 정확도의 지도 ImageNet 모델보다 훨씬 더 견고하다는 것을 발견

제안모델 설명

- 아이디어: 자연어와 이미지가 함께 연결된 감독을 통해 지각을 학습

1. 충분히 큰 데이터셋 생성 + 2. 사전 훈련 방법 선택 + 3. 모델 선택 및 확장 순으로 설명하도록 하겠습니다.

1. 충분히 큰 데이터셋 생성

[기존 데이터셋]

- 주로 MS-COCO, Visual Genome, YFCC100M 세 가지 데이터셋을 사용해옴

- MS-COCO & Visual Genome: 고품질의 크라우드 라벨링된 데이터셋이지만, 현대 기준에서는 각각 약 10만 개의 훈련용 사진으로 비교적 작다

- YFCC100M은 1억 개의 사진을 가지지만, 각 이미지에 대한 메타데이터가 희소하며 품질이 다양함

- 이미지는 "제목"으로 자동 생성된 파일명(예: 20160716 113957.JPG)을 사용하거나 카메라 노출 설정과 같은 "설명"을 포함

- 영어로 된 자연어 제목 및/또는 설명이 있는 이미지만 유지하기 위해 필터링한 결과, 데이터셋은 6배로 축소되어 약 1,500만 개의 사진만 남음(ImageNet과 거의 같은 크기).

☞ 데이터 사이즈가 너무 작음

[본 논문에서 생성한 데이터셋]

- 인터넷에서 공개된 다양한 소스에서 수집한 4억 개의 (이미지, 텍스트) 쌍의 새 데이터셋을 구축

- 가능한 넓은 범위의 시각적 개념을 다루기 위해 구성 프로세스의 일부로 텍스트에 50만 개의 쿼리 중 하나가 포함된 (이미지, 텍스트) 쌍을 찾음

- 결과를 약 2만 개의 (이미지, 텍스트) 쌍 당 최대 2만개의 (이미지, 텍스트) 쌍까지 포함하여 대략적으로 클래스 밸런스를 조정

- 이 데이터셋을 WebImageText(WIT)로 참조함

☞결과적으로 얻은 데이터셋은 GPT-2를 훈련하는 데 사용된 WebText 데이터셋과 비슷한 총 단어 수 가짐

2. 사전 훈련 방법 선택

[초기 접근 방식] VirTex와 유사하게 이미지 CNN과 텍스트 트랜스포머를 처음부터 함께 훈련하여 이미지의 캡션을 예측

- 이미지 인코더의 ResNet50에 비해 두 배의 계산을 사용하는 6300만 개의 파라미터 트랜스포머 언어 모델

- 동일한 텍스트의 bag-of-words 인코딩을 예측하는 Joulin et al. (2016)과 유사한 접근 방식보다, ImageNet 클래스를 인식하는 속도가 세 배 느림

→ 이 방법을 효율적으로 확장하는 데 어려움

[채택한 방식] 예측적 목표를 대조적 목표로 바꿈

- contrastive representation learning 최근의 작업은 대조적 목표가 동등한 예측적 목표보다 우월할 수 있다는 것을 발견 (Tian et al., 2019). → 이 결과를 고려하여 어려운 부분의 해결을 시도

- (단어의 정확한 예측이 아닌) 텍스트 전체가 이미지와 결합되는 것을 예측하는 잠재적으로 더 쉬운 프록시 작업을 풀기 위해 시스템을 훈련 결정

- N개의 (이미지, 텍스트) 쌍의 배치가 주어지면, 배치 전체에서 발생한 가능한 N × N개의 (이미지, 텍스트) 쌍 중 실제로 발생한 것을 예측하도록 훈련됨

→ 이를 위해, 배치 내의 N개의 실제 쌍의 이미지 및 텍스트 임베딩의 코사인 유사성을 최대화하고, N2 - N 부적절한 쌍의 임베딩의 코사인 유사성을 최소화하여, 다중 모달 임베딩 공간을 학습함 (유사성 점수에 대해 대칭 크로스 엔트로피 손실을 최적화)

- 사전 훈련된 가중치를 초기화하는 대신 CLIP를 처음부터 훈련시킴

- 표현과 대조적인 임베딩 공간 사이의 비선형 프로젝션을 제거

- 각 인코더의 표현을 다중 모달 임베딩 공간으로 매핑하는 데 선형 프로젝션만 사용함

- 사전 훈련 데이터셋의 많은 (이미지, 텍스트) 쌍이 하나의 문장일 뿐이기 때문에, 텍스트 변형 함수 tu를 제거함

- 이미지 변형 함수 tv도 단순화함

- 훈련 중에 사용되는 유일한 데이터 증가는 크기 조정된 이미지에서의 무작위 정사각형 자르기뿐

- 소프트맥스에서 로짓의 범위를 제어하는 온도 매개변수 τ를 하이퍼 파라미터로 변환하지 않고 훈련 중에 직접 최적화함

결과: ImageNet으로의 제로 샷 전이 속도를 추가로 4배 개선시킴

3. 모델 선택 및 확장

- 이미지 인코더에 대해 두 가지 다른 아키텍처를 고려함

[1st 아키텍처] ResNet50 기반 이미지 인코더

- ResNet50을 기본 아키텍처로 선택하여 이미지 인코더를 구축.

- ResNetD의 개선과 안티알리어싱된 rect-2 blur pooling을 적용하여 성능을 향상기킴.

- 전역 평균 풀링 레이어를 어텐션 풀링 메커니즘으로 대체하여 이미지 표현을 향상시킴

[2nd 아키텍처] Vision Transformer 기반 이미지 인코더

- 최근에 소개된 Vision Transformer를 실험적으로 적용하여 이미지 인코더를 구축

- 기존의 구현을 따르되 초기화 체계와 레이어 정규화에 약간의 수정을 가함

- 또한, 텍스트 인코더는 Transformer를 기반으로 하며, 텍스트의 BPE 표현을 사용하여 작동한다. 모델의 너비와 깊이를 확장하는 것은 ResNet 이미지 인코더에만 적용되며, 텍스트 인코더에는 너비 조정만 적용된다. 이는 CLIP의 성능이 텍스트 인코더에 대해 덜 민감하다는 사실을 고려한 결정이다.

평가 결과 분석

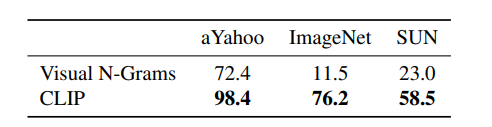

- CLIP와 Visual N-Grams의 성능(정확도) 비교

- CLIP의 zero-shot 성능을 다양한 데이터셋과 작업에 대해 분석함

- 3개의 데이터셋에서부터 시작하여, 30개 이상의 데이터셋과 50개 이상의 기존 컴퓨터 비전 시스템과의 비교를 포함

- STL10에서 99.3%로 새로운 최고 성능을 보이는 등 다양한 작업에서 좋은 결과 보임

- 특정 작업에서는 전문가 수준의 성능을 보이는 반면, 기타 특정 작업에서는 성능이 낮은 것으로 나타남 → CLIP이 특정 작업에 대한 이해도에 따라 성능이 달라지는 것을 시사함

- Zero-shot CLIP few-shot linear probes보다 우수한 성능 보임.

- CLIP 모델의 선형 분류 성능을 최신 컴퓨터 비전 모델과 비교한 결과

- Zero-shot CLIP는 표준 ImageNet 모델보다 분포 이동에 훨씬 강건함

논문의 한계점 및 기여점

[한계]

1. 전반적인 SOTA보다 성능이 훨씬 낮다.

- CLIP의 작업 학습 및 전이 기능을 개선하기 위해 상당한 작업이 필요

- SOTA 성능에 도달하기 위해 제로샷 CLIP에 대해 약 1000배의 컴퓨팅 증가가 필요한 것으로 추정됨

☞ CLIP의 계산 및 데이터 효율성을 개선하기 위한 추가 연구가 필요

2. 제로샷 전송 개발을 안내하기 위해 반복적으로 검증 세트에서 성능을 쿼리함

- 진정한 제로샷 시나리오에 대해 비현실적이다.

3. 또 다른 잠재적인 문제인 평가 데이터셋의 선택

- 본 논문은 표준화된 컬렉션으로 Kornblith et al. (2019)의 12개 데이터셋 평가 모음에서 결과를 보고하지만,

주된 분석은 CLIP의 능력과 명백하게 공조된 다소 임의적인 27개의 데이터셋 모음을 사용

→ 넓은 제로샷 전송 능력을 평가하기 위해 설계된 작업의 새로운 벤치마크는 이 문제를 해결하는 데 도움이 될 것

4. 본 논문은 자연어를 통해 이미지 분류기를 지정하는 것이 유연한 인터페이스임을 강조하지만, 제한 있음

- 많은 복잡한 작업은 텍스트만으로 명시하기 어려울 수 있다.

- 실제 훈련 예제는 확실히 유용하지만, CLIP은 직접 소수의 샷 성능을 최적화하지 않음.

[기여점]

- 제로샷 전송 성능: CLIP 모델은 제로샷 전송 능력을 갖추고 있으며, 기존의 이미지 분류 데이터셋에 대해 뛰어난 성능을 보인다. 이는 모델이 이미지와 텍스트 쌍에 대한 이해를 바탕으로 새로운 작업에 적응할 수 있음을 시사한다.

- 모델의 유연성: CLIP 모델은 다양한 작업을 수행하기 위해 사전 훈련되었으며, 자연어 프롬프트를 통해 이러한 작업을 수행할 수 있다. 이는 모델의 유연성을 강조하며, 새로운 작업에 대한 조정이나 확장이 가능함을 보여준다.

- 분야 간 전이 가능성: 이 연구는 자연어 처리 분야의 성공적인 사전 훈련 모델이 컴퓨터 비전 분야로도 전이될 수 있음을 시사한다. 이는 모델의 효율적인 다용도 사용을 가능하게 한다.